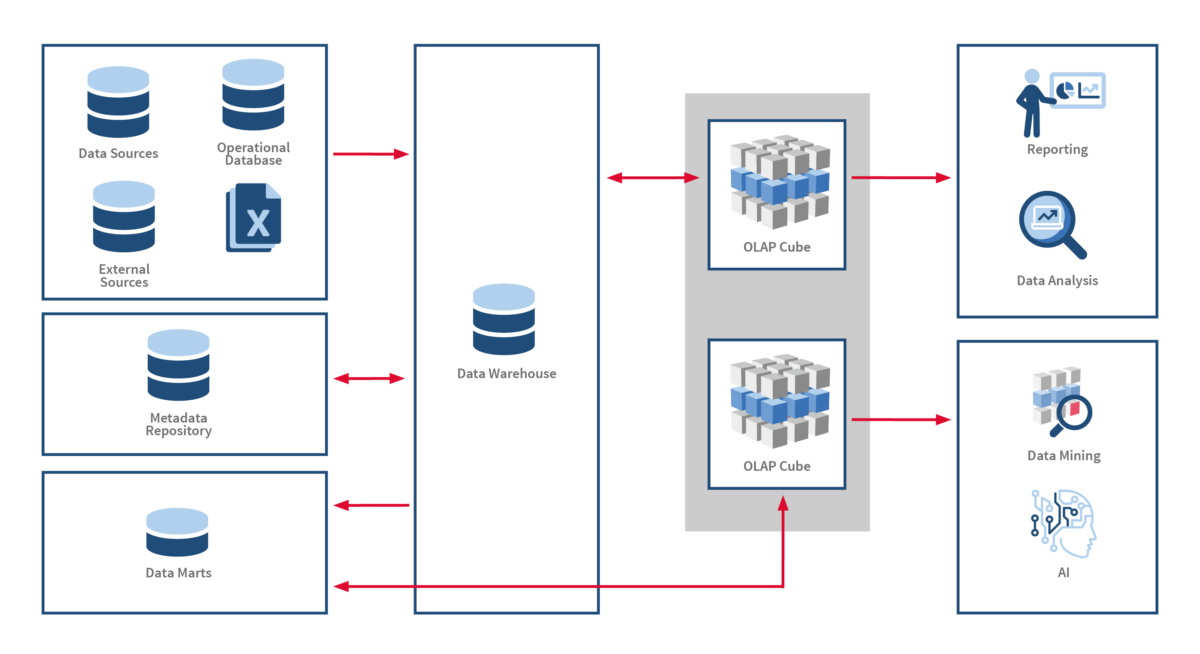

Data Warehouse

Zentrale Datenquelle für unternehmerische Entscheidungen

Das Data Warehouse (DWH) ist aus erfolgreichen Firmen nicht mehr wegzudenken und beinhaltet alle wichtigen Informationen zur erfolgreichen Unternehmenssteuerung. Die digitale Transformation stellt bestehende Architekturen aber vor immer größeren Herausforderungen. Wir helfen Ihnen sowohl bei der Einführung eines neuen Data Warehouses als auch bei der Modernisierung und Zukunftssicherung bereits bestehender Architekturen.

Unsere Leistungen für Ihr leistungsstarkes

und modernes Data Warehouse

Architektur & Technologie-Beratung

Profitieren Sie von unserer über

15-jährige Erfahrung in der Entwicklung von Data Warehouses. Wir beraten lösungsorientiert und Technologie-unabhängig.

15-jährige Erfahrung in der Entwicklung von Data Warehouses. Wir beraten lösungsorientiert und Technologie-unabhängig.

Modellierung & Data Vault

Unsere DWH-Spezialisten wählen gemeinsam mit Ihnen die passende Modellierungsmethode aus. Neben klassischen Methoden verfügen unsere Experten über tiefe Data Vault Modellierungsexpertise.

Implementierung

Unsere DWH-Entwickler bauen Ihr neues DWH oder erweitern bestehende Strukturen.

Modernisierung

Unsere DWH-Experten unterstützen und beraten Sie in Architekturfragen sowie bei Modernisierungsmaßnahmen in Bezug auf Skalierbarkeit, Self-Service, Big Data und Automatisierung.

Cloud

Wir arbeiten eng mit führenden Cloud-DWH Anbietern zusammen. Gemeinsam mit Ihnen setzen wir eine Anwendungsarchitektur um, die Ihre komplexen Anforderungen an Skalierbarkeit & Performance erfüllt. Bestehende On-Premise DWH‘s migrieren wir kostengünstig in die Cloud.

Support

In bestehenden Enterprise Umgebungen übernehmen wir für Sie den Support und stellen die Verfügbarkeit Ihres DWH sicher.

Christopher Keller

Director Big Data Analytics & IoT

Wir bauen und optimieren Ihr Data Warehouse

it-novum ist Ihr Spezialist für das Data Warehouse

Data Warehouse Expertise

Unsere DWH-Projekte sind erfolgreich, weil unsere jahrelangen Erfahrung aus zahlreichen DWH-Projekten auch in Ihre Implementierung einfließt.

Open Minded

Um Mehrwerte für Ihr Unternehmen zu generieren, bringen wir Erkenntnisse aus Projektumsetzungen in verschiedensten Branchen in Ihr Projekt ein.

Technologie Know-How

Um Ihnen stets state-of-the-art Lösungen zu liefern, erweitern wir unser Portfolio ständig um neueste Technologien, die zielführend in unseren Projekten eingesetzt werden.

Zertifiziertes Personal

Um Ihnen qualitativ höchste Expertenleistung zu bieten, ist unser großes Technologieteam in bewährten und modernen Methoden, Technologien und Architekturen geschult und zertifiziert.